モリカトロン株式会社運営「エンターテインメント×AI」の最新情報をお届けするサイトです。

- TAG LIST

- CGCGへの扉生成AI安藤幸央吉本幸記月刊エンタメAIニュース河合律子機械学習ディープラーニングOpenAILLM大規模言語モデルGoogleNVIDIA音楽グーグルGANモリカトロン森川幸人ChatGPT三宅陽一郎Stable DiffusionDeepMind強化学習人工知能学会ニューラルネットワークシナリオマイクロソフトQA自然言語処理AIと倫理GPT-3倫理Facebook大内孝子映画SIGGRAPHスクウェア・エニックス著作権アートキャラクターAIルールベースゲームプレイAIMinecraft敵対的生成ネットワークNPC音楽生成AI動画生成AIモリカトロンAIラボインタビューアニメーション3DCG画像生成NFTロボットファッションDALL-E2StyleGANプロシージャルディープフェイクマルチモーダルVFXMidjourney遺伝的アルゴリズムデバッグ自動生成VRメタAIMeta画像生成AIRed RamマンガインタビューゲームAIAdobeMicrosoftテストプレイマインクラフト小説CLIPテキスト画像生成深層学習CEDEC2019toio教育NeRFデジタルツインメタバース不完全情報ゲームStability AIボードゲームDALL-ESoraビヘイビア・ツリーCEDEC2021CEDEC2020作曲アストロノーカロボティクスナビゲーションAI高橋力斗AIアートGeminiメタ畳み込みニューラルネットワークアップルデジタルヒューマンELSIPlayable!スポーツはこだて未来大学エージェントGDC 2021プロンプトGPT-4手塚治虫汎用人工知能JSAI20223D広告DALL-E 3バーチャルヒューマンNVIDIA OmniverseGDC 2019マルチエージェントCEDEC2022市場分析AR懐ゲーから辿るゲームAI技術史鴫原盛之ジェネレーティブAIソニー東京大学栗原聡CNNマーケティングJSAI2024CMBERTMicrosoft Azure音声認識言霊の迷宮UnityOmniverseUbisoftJSAI2023Robloxがんばれ森川君2号電気通信大学SIGGRAPH ASIAHTNApple階層型タスクネットワークAIQVE ONE世界モデルアドベンチャーゲームインディーゲームJSAI2020GTC2023音声合成メタデータTensorFlowブロックチェーンイベントレポートキャリア模倣学習対話型エージェントAmazonサイバーエージェントトレーディングカードメディアアートDQNシーマン合成音声SIERunway水野勇太モリカトロン開発者インタビュー宮本茂則アバターブラック・ジャックGenvid TechnologiesガイスターStyleGAN2徳井直生村井源稲葉通将斎藤由多加Open AIベリサーブGTC2022GPT-3.5YouTube音声生成AISFNetflixJSAI2021松木晋祐Bard研究シムシティシムピープルZorkGPT-4oMCS-AI動的連携モデルマーダーミステリーモーションキャプチャーTEZUKA2020CEDEC2023AGIテキスト生成スパーシャルAIElectronic ArtsGDC Summerイーロン・マスク論文Stable Diffusion XL森山和道Audio2FaceNVIDIA Rivaeスポーツスタンフォード大学アーケードゲームテニスセガ人狼知能Google I/O類家利直FireflyeSportsBLUE PROTOCOLCEDEC2024aibo大澤博隆SFプロトタイピング銭起揚Runway Gen-3 AlphaチャットボットTikToktext-to-3DDreamFusion自動運転車ワークショップEpic GamesAIロボ「迷キュー」に挑戦AWSAdobe MAXクラウドAlphaZeroPreferred NetworksTransformerGPT-2rinnaAIりんなカメラ環世界中島秀之PaLMGitHub CopilotLLaMA哲学Apple Vision Proハリウッド宮路洋一Whisk理化学研究所Gen-1SIGGRAPH Asia 2024テキスト画像生成AI松尾豊人事データマイニングControlNet現代アートDARPA法律ドローンゲームエンジンUnreal EngineImagen人工生命バイアスサム・アルトマンVeoASBSぱいどんAI美空ひばり手塚眞LoRAデザインGDC 2025バンダイナムコ研究所ELYZANEDO建築ELIZAFSM-DNNMindAgentBIMLEFT 4 DEADくまうた通しプレイソニー・インタラクティブエンタテインメントOpenAI FiveMeshy本間翔太馬淵浩希Cygames岡島学ピクサー九州大学プラチナエッグイーサリアム効果音ボエダ・ゴティエビッグデータ中嶋謙互Amadeus Codeデータ分析自動翻訳MILENVIDIA ACEVeo 3ナラティブNianticOmniverse ReplicatorWCCFレコメンドシステムNVIDIA DRIVE SimWORLD CLUB Champion FootballNVIDIA Isaac SimSakana AI柏田知大軍事田邊雅彦トレカ慶應義塾大学Max CooperGPTDisneyPhotoshopPyTorch京都芸術大学ChatGPT4モンテカルロ木探索JSAI2025ByteDance眞鍋和子バンダイナムコスタジオコミコパヒストリアAI Frog Interactive新清士ラベル付け田中章愛ComfyUI齊藤陽介コナミデジタルエンタテインメント成沢理恵お知らせMagic Leap OneTencentサッカーバスケットボールLINEヤフーSuno AIKaKa CreationVOICEVOXtext-to-imageサルでもわかる人工知能VAETEZUKA2023DOOMリップシンキングRNNGameNGenグランツーリスモ・ソフィーUbisoft La Forgeスーパーマリオブラザーズ社員インタビュー知識表現ウォッチドッグス レギオンVTuberIGDA立教大学秋期GTC2022大阪公立大学HALOフォートナイトKLabどうぶつしょうぎジェイ・コウガミ音楽ストリーミングMIT野々下裕子Movie GenQosmoマシンラーニング5GMuZeroRival Peakpixivオムロン サイニックエックスGPTsセキュリティ対話エンジンポケモン3Dスキャン橋本敦史リトル・コンピュータ・ピープルCodexシーマン人工知能研究所コンピューティショナル・フォトグラフィーゴブレット・ゴブラーズ絵画3D Gaussian SplattingMicrosoft DesignerイラストシミュレーションSoul Machines柿沼太一完全情報ゲームバーチャルキャラクター坂本洋典宮本道人釜屋憲彦LLaMA 2ウェイポイントパス検索Hugging Face対談藤澤仁生物学XRGTC 2022xAI画像認識SiemensストライキStyleCLIPDeNAVoyager長谷洋平GDC 2024クラウドコンピューティングmasumi toyotaIBMぎゅわんぶらあ自己中心派OpenSeaGDC 2022Veo 2ウロチョロスSNSTextWorldEarth-2BingエコロジーMagentaソフトバンクSONYポケットモンスターELYZA PencilScenarioSIGGRAPH2023AIピカソGTC2021AI素材.comCycleGANテンセントAndreessen HorowitzQA Tech NightNetHack下田純也桑野範久キャラクターモーション音源分離NBAフェイクニュースユニバーサルミュージックRPGウィル・ライトWeb3SIGGRAPH 2022レベルデザインDreamerV3SIMAAIボイスアクター南カリフォルニア大学NVIDIA CanvasGDCGPUALifeオルタナティヴ・マシンサウンドスケープLaMDATRPGマジック:ザ・ギャザリングAI Dungeon介護BitSummitGemma 2Cube 3DゼビウスNetEaseInworld AIモリカトロンAIコネクトゲーム背景IEEEPoint-EアパレルClaude不気味の谷ナビゲーションメッシュファインチューニング早稲田大学グランツーリスモ写真高橋ミレイ北野宏明深層強化学習松原仁松井俊浩武田英明フルコトモリカコミックパックマンELYZA DIGESTジョージア工科大学Apple IntelligenceWWDCWWDC 2024西成活裕ハイブリッドアーキテクチャAI野々村真LINE AIトークサジェストApex Legends群衆マネジメントライブポートレイトGTC2025NinjaコンピュータRPGライブビジネスWonder StudioAdobe Max 2023GPT-4-turboFuxi Labアップルタウン物語新型コロナ土木佐藤恵助Naraka:Bladepoint MobileKELDIC周済涛Bing Chat大道麻由バトルロイヤルメロディ言語清田陽司インフラBing Image Creator物語構造分析ビヘイビアツリーゲームTENTUPLAYサイバネティックス慶応義塾大学SoftServeMARVEL Future FightAstro人工知能史Amazon BedrockAssistant with Bard渡邉謙吾ALNAIRタイムラプスEgo4DAI哲学マップThe Arcadeここ掘れ!プッカAMRIバスキア星新一X.AISearch Generative ExperienceBLADE日経イノベーション・ラボStyleGAN-XLX Corp.Dynalang濱田直希GAGA敵対的強化学習StyleGAN3TwitterVLE-CE大柳裕⼠QUEEN階層型強化学習GOSU Data LabGANimatorXホールディングス加納基晴Runway Gen-4WANNGOSU Voice AssistantVoLux-GANMagiAI ActSkyReels竹内将SenpAI.GGProjected GANEU研究開発事例MobalyticsSelf-Distilled StyleGANSDXLArs Electronica赤羽進亮Stable Virtual CameraニューラルレンダリングRTFKTAI規制遊戯王IntangibleAWS SagemakerPLATONIKE欧州委員会UDI(Universal Duel Interface)ブライアン・イーノ映像セリア・ホデント形態素解析frame.ioClone X欧州議会第一工科大学EnoUXAWS LambdaFoodly村上隆欧州理事会佐竹空良Brain One誤字検出MusicLM小林篤史AlphaEvolve認知科学中川友紀子Digital MarkAudioLMContinuous Thought Machine(CTM)ゲームデザインSentencePieceアールティSnapchatMusicCaps荻野宏実ArmLUMINOUS ENGINEクリエイターコミュニティAudioCraft伊藤黎Stable Audio Open SmallLuminous ProductionsBlenderBot 3バーチャルペットビヘイビアブランチWord2Worldパターン・ランゲージ竹村也哉Meta AINVIDIA NeMo ServiceMubertWPPSTORY2GAMEちょまどマーク・ザッカーバーグヴァネッサ・ローザMubert RenderGeneral Computer Control(GCC)ウィットウォーターランド大学GOAPWACULVanessa A RosaGen-2Cradle森川の頭の中Adobe MAX 2021陶芸Runway AI Film FestivalSpiral.AI花森リドPlay.htPreVizItakoLLM-7bGoogle I/O 2025音声AI静岡大学AIライティングLiDARCharacter-LLM明治大学FlowOmniverse AvatarAIのべりすとPolycam復旦大学北原鉄朗Lyra 2FPSQuillBotdeforumChat-Haruhi-Suzumiya中村栄太MusicFX DJマルコフ決定過程NVIDIA MegatronCopysmith涼宮ハルヒ日本大学Animon.aiNVIDIA MerlinJasperハーベストEmu VideoヤマハツインズひなひまNVIDIA MetropolisForGames前澤陽Mayaパラメータ設計ゲームマーケットペリドット増田聡Deep Q-Learningバランス調整岡野翔太Dream Track採用AlphaGO協調フィルタリング郡山喜彦Music AI Toolsスペースインベーダーテキサス大学ジェフリー・ヒントンLyria科学史プリンス・オブ・ペルシャGoogle I/O 2023Yahoo!知恵袋AIサイエンティストドラゴンクエストIVAlphaDogfight TrialsAI Messenger VoicebotインタラクティブプロンプトAITerra堀井雄二エージェントシミュレーションOpenAI Codex武蔵野美術大学AI Overview山名学StarCraft IIHyperStyleBingAI石渡正人電通タイトーFuture of Life InstituteRendering with Style手塚プロダクションAICO2カプコンIntel林海象BitSummit DriftUbi AnvilエンジンLAIKADisneyリサーチヴィトゲンシュタイン古川善規V1 Video ModelRotomationGauGAN論理哲学論考Lightroom大規模再構成モデルOmega CrafterArtificial AnalysisGauGAN2CanvaLRMSPACE INVADIANSVideo Arenaドラゴンクエストライバルズ画像言語表現モデルObjaverse西島大介Video Model Leaderboard不確定ゲームSIGGRAPH ASIA 2021PromptBaseBOOTHMVImgNet吉田伸一郎Claude 3.5Dota 2ディズニーリサーチpixivFANBOXOne-2-3-45SIGGRAPH2024MistralMitsuba2バンダイナムコネクサス虎の穴3DガウシアンスプラッティングMotion-I2VソーシャルゲームEmbeddingワイツマン科学研究所ユーザーレビューFantiaワンショット3D生成技術樋口恭介GTC2020CG衣装mimicとらのあなToonify3DClaude 4NVIDIA MAXINEVRファッションBaidu集英社FGDC生成対向ネットワーク小川 昴淡路滋ビデオ会議ArtflowERNIE-ViLG少年ジャンプ+Future Game Development Conference拡散モデルホラーゲームグリムノーツEponym古文書ComicCopilot佐々木瞬DiffusionStable Diffusion 1.5ゴティエ・ボエダ音声クローニング凸版印刷階層型物語構造Gautier Boeda階層的クラスタリングGopherAI-OCRゲームマスターうめ夏目漱石画像判定Inowrld AI小沢高広漱石書簡Julius鑑定MODAniqueドリコム京都情報大学院大学TPRGOxia PalusGhostwriter中村太一ai and上野未貴バーチャル・ヒューマン・エージェントtoio SDK for UnityArt RecognitionSkyrimエグゼリオSaaSクーガー実況パワフルサッカースカイリムCopilotインサイト石井敦NHC 2021桃太郎電鉄RPGツクールMZカスタマーサポート茂谷保伯池田利夫桃鉄ChatGPT_APIMZserial experiments lainComfyUI-AdvancedLivePortraitGDMC新刊案内パワサカダンジョンズ&ドラゴンズAI lainGUIマーベル・シネマティック・ユニバースOracle RPGPCGMITメディアラボMCU岩倉宏介深津貴之PCGRLアベンジャーズPPOxVASynthDungeons&DragonsVideo to Videoマジック・リープDigital DomainMachine Learning Project CanvasLaser-NVビートルズiPhone 16MagendaMasquerade2.0国立情報学研究所ザ・ビートルズ: Get BackOpenAI o1ノンファンジブルトークンDDSPフェイシャルキャプチャー石川冬樹MERFDemucsAIスマートリンクスパコンAlibaba音楽編集ソフトシャープ里井大輝KaggleスーパーコンピュータVQRFAdobe Auditionウェアラブル山田暉松岡 聡nvdiffreciZotopeCE-LLMAssassin’s Creed OriginsAI会話ジェネレーターTSUBAME 1.0NeRFMeshingRX10Communication Edge-LLMSea of ThievesTSUBAME 2.0LERFMoisesGEMS COMPANYmonoAI technologyLSTMABCIマスタリングAIペットモリカトロンAIソリューション富岳レベルファイブYahoo!ニュース初音ミクOculusコード生成AISociety 5.0リアム・ギャラガーAI Comic Factory転移学習テストAlphaCode夏の電脳甲子園グライムスAI comic GeneratorBaldur's Gate 3Codeforces座談会BoomyComicsMaker.aiCandy Crush Saga自己増強型AIジョン・レジェンドGenie AILlamaGen.aiSIGGRAPH ASIA 2020COLMAPザ・ウィークエンドSIGGRAPH Asia 2023GAZAIADOPNVIDIA GET3DドレイクC·ASEFlame PlannerデバッギングBigGANGANverse3DFLARE動画ゲーム生成モデルMaterialGANダンスグランツーリスモSPORTAI絵師エッジワークスMagicAnimateReBeLUGC日本音楽作家団体協議会Animate AnyoneVirtuals ProtocolGTソフィーPGCFCAインテリジェントコンピュータ研究所VolvoFIAグランツーリスモチャンピオンシップVoiceboxアリババMarioVGGNovelAIさくらインターネットDreaMovingRival PrakDGX A100NovelAI DiffusionVISCUIT松原卓二ぷよぷよScratchArt Transfer 2ユービーアイソフトWebcam VTuberモーションデータスクラッチArt Selfie 2星新一賞ビスケットMusical Canvas北尾まどかポーズ推定TCGプログラミング教育The Forever Labyrinth将棋メタルギアソリッドVメッシュ生成Refik AnadolFSMメルセデス・ベンツQRコードVALL-EAlexander RebenMagic Leap囲碁Deepdub.aiRhizomatiksナップサック問題Live NationEpyllionデンソーAUDIOGENMolmo汎用言語モデルWeb3.0マシュー・ボールデンソーウェーブEvoke MusicPixMoAIOpsムーアの法則原昌宏AutoFoleyQwen2 72BSpotifyスマートコントラクト日本機械学会Colourlab.AiDepth ProReplica Studioロボティクス・メカトロニクス講演会ディズニーamuseChitrakarAdobe MAX 2022トヨタ自動車Largo.aiVARIETAS巡回セールスマン問題かんばん方式CinelyticAI面接官ジョルダン曲線メディアAdobe ResearchTaskadeキリンホールディングス政治Galacticaプロット生成Pika.art空間コンピューティングクラウドゲーミングAI Filmmaking AssistantDream Screen和田洋一リアリティ番組映像解析FastGANSynthIDStadiaジョンソン裕子4コママンガAI ScreenwriterFirefly Video ModelMILEsNightCafe東芝デジタルソリューションズ芥川賞Stable Video 4Dインタラクティブ・ストリーミングLuis RuizSATLYS 映像解析AI文学AI受託開発事例インタラクティブ・メディア恋愛田中志弥PFN 3D ScanElevenLabsタップルPlayable!3D東京工業大学HeyGenAbema TVPlayable!MobileLudo博報堂After EffectsNECAdobe MAX 2024ラップPFN 4D Scan絵本木村屋SneaksSIGGRAPH 2019ArtEmisZ世代DreamUp出版GPT StoreIllustratorAIラッパーシステムDeviantArtAmmaar Reshi生成AIチェッカーMeta Quest 3Waifu DiffusionStoriesユーザーローカルXR-ObjectsGROVERプラスリンクス ~キミと繋がる想い~元素法典StoryBird九段理江PeridotFAIRSTCNovel AIVersed東京都同情塔Orionチート検出Style Transfer ConversationProlificDreamer防犯オンラインカジノRCPUnity Sentis4Dオブジェクト生成モデルO2RealFlowRinna Character PlatformUnity MuseAlign Your GaussiansScam DetectioniPhoneCALACaleb WardAYGLive Threat DetectionDeep Fluids宮田龍MAV3D乗換NAVITIMEMeInGameAmelia清河幸子ファーウェイKaedimAIGraphブレイン・コンピュータ・インタフェース西中美和4D Gaussian Splatting3DFY.aiBCIGateboxアフォーダンス安野貴博4D-GSLuma AILearning from VideoANIMAKPaLM-SayCan斧田小夜GlazeAvaturn予期知能逢妻ヒカリWebGlazeBestatセコムNightShadeOasisユクスキュルバーチャル警備システムCode as PoliciesSpawningDecartカント損保ジャパンCaPHave I Been Trained?Dejaboom!CM3leonFortniteUnbounded上原利之Stable DoodleUnreal Editor For FortniteEtchedドラゴンクエストエージェントアーキテクチャアッパーグラウンドコリジョンチェックT2I-Adapter声優PAIROCTOPATH TRAVELERパブリシティ権西木康智Volumetrics日本俳優連合OCTOPATH TRAVELER 大陸の覇者山口情報芸術センター[YCAM]AIワールドジェネレーター日本芸能マネージメント事業者協会アルスエレクトロニカ2019品質保証YCAM日本マネジメント総合研究所Rosebud AI Gamemaker日本声優事業社協議会StyleRigAutodeskアンラーニング・ランゲージLayerIAPP逆転オセロニアBentley Systemsカイル・マクドナルドLily Hughes-RobinsonCharisma.aiTripo 2.0ワールドシミュレーターローレン・リー・マッカーシーColossal Cave AdventureMeta 3D Gen奥村エルネスト純いただきストリートH100鎖国[Walled Garden]プロジェクトAdventureGPT調査スマートシティ齋藤精一大森田不可止COBOLSIGGRAPH ASIA 2022リリー・ヒューズ=ロビンソンMeta Quest都市計画高橋智隆DGX H100VToonifyBabyAGIIP松本雄太ロボユニザナックDGX SuperPODControlVAEGPT-3.5 Turbo早瀬悠真泉幸典仁井谷正充変分オートエンコーダーカーリング強いAIGenie 2ロボコレ2019Instant NeRFフォトグラメトリウィンブルドン弱いAIWorld Labsartonomous回帰型ニューラルネットワークCybeverbitGANsDeepJoin戦術分析Third Dimension AIAzure Machine LearningAzure OpenAI Serviceパフォーマンス測定Lumiere東北大学意思決定モデル脱出ゲームDeepLIoTUNetGemini 2.0Hybrid Reward Architectureコミュニティ管理DeepL WriteProFitXImageFXSuper PhoenixWatsonxMusicFXProject MalmoオンラインゲームAthleticaTextFXフロンティアワークス気候変動コーチング機械翻訳Project Paidiaシンギュラリティ北見工業大学KeyframerSimplifiedProject Lookoutマックス・プランク気象研究所レイ・カーツワイル北見カーリングホールAI Voice over GeneratorWatch Forビョルン・スティーブンスヴァーナー・ヴィンジ画像解析Gemini 1.5AI Audio Enhancer気象モデルRunway ResearchじりつくんAI StudioエーアイLEFT ALIVE気象シミュレーションMake-A-VideoNTT SportictVertex AIAITalk長谷川誠ジミ・ヘンドリックス環境問題PhenakiAIカメラChat with RTXコエステーションBaby Xカート・コバーンDreamixSTADIUM TUBESlackロバート・ダウニー・Jr.エイミー・ワインハウスSDGsText-to-ImageモデルPixelllot S3Slack AIPlayStationPokémon Battle Scopeダフト・パンクメモリスタAIスマートコーチVRMLGlenn MarshallkanaeruTechno MagicThe Age of A.I.Story2Hallucination音声変換Latitude占いゴーストバスターズレコメンデーションJukeboxDreambooth行動ロジック生成AIスパイダーマンVeap Japanヤン・ルカンConvaiポリフォニー・デジタルEAPneoAIPerfusionNTTドコモ荒牧伸志SIFT福井千春DreamIconニューラル物理学EmemeProject SidDCGAN医療mign毛髪GenieAlteraMOBADANNCEメンタルケアstudiffuse荒牧英治汎用AIエージェントRobert Yangハーバード大学Edgar Handy中ザワヒデキAIファッションウィークRazer研修デューク大学大屋雄裕インフルエンサーProject AVA中川裕志Grok-1Streamlabsmynet.aiローグライクゲームAdreeseen HorowitzMixture-of-ExpertsIntelligent Streaming Assistant東京理科大学NVIDIA Avatar Cloud EngineMoEProject DIGITS人工音声NeurIPS 2021産業技術総合研究所Replica StudiosClaude 3スーパーコンピューターリザバーコンピューティングSmart NPCsClaude 3 Haikuエージェンテックプレイ動画ヒップホップ対話型AIモデルRoblox StudioClaude 3 SonnetAI Shorts詩ソニーマーケティングPromethean AIClaude 3 Opusテルアビブ大学サイレント映画もじぱnote森永乳業DiffUHaul環境音暗号通貨note AIアシスタントMusiioC2PATrailBlazerFUZZLEKetchupEndelゲーミフィケーションヴィクトリア大学ウェリントンAlterationAI NewsTomo Kiharazeroscope粒子群最適化法Art SelfiePlayfoolQNeRF進化差分法オープンワールドArt TransferSonar遊びカーネギーメロン大学群知能下川大樹AIFAPet PortraitsSonar+DtsukurunRALF高津芳希P2EBlob Opera地方創生グラフィック大石真史クリムトDolby Atmos吉田直樹メイクBEiTStyleGAN-NADASonar Music Festival素材CanvasDETRライゾマティクスProjectsSporeクリティックネットワーク真鍋大度OpenAI JapanDeepSeekデノイズUnity for Industryアクターネットワーク花井裕也Voice EngineDeepSeek-R1画像処理DMLabRitchie HawtinCommand R+SentropyGLIDEControl SuiteErica SynthOracle Cloud InfrastructureLoopyCPUDiscordAvatarCLIPAtari 100kUfuk Barış MutluGoogle WorkspaceリップシンクSynthetic DataAtari 200MJapanese InstructBLIP AlphaUdioCyberHostCALMYann LeCun日本新聞協会立命館大学OmniHuman-1プログラミング鈴木雅大AIいらすとや京都精華大学CSAMソースコード生成コンセプトアートAI PicassoTacticAIImagen 3GMAIシチズンデベロッパーSonanticColie WertzEmposyNPMPGoogle LabsGitHubCohereリドリー・スコットAIタレントFOOHMicrosoft MuseウィザードリィMCN-AI連携モデル絵コンテAIタレントエージェンシーゲーム生成モデルUrzas.aiストーリーボードmodi.aiProject AstraWHAMデモンストレーター大阪大学Google I/O 2024ChatGPT Edu西川善司並木幸介KikiBlenderBitSummit Let’s Go!!滋賀大学サムライスピリッツ森寅嘉Zoetic AISIGGRAPH 2021ペット感情認識キリンビールストリートファイター半導体Digital Dream LabsPaLM APIデジタルレプリカ音声加工桜AIカメラTopaz Video Enhance AICozmoMakerSuiteGOT7マルタ大学Solist-AIDLSSタカラトミーSkebsynthesia田中達大ローム山野辺一記LOVOTDreambooth-Stable-DiffusionHumanRF大里飛鳥DynamixyzMOFLINActors-HQMove AIベンチマークRomiGoogle EarthSAG-AFTRAICRA2024FactorioU-NetミクシィGEPPETTO AIWGAHao AI Lab13フェイズ構造ユニロボットStable Diffusion web UIチャーリー・ブルッカー大規模基盤モデルカリフォルニア大学ADVユニボToroboGamingAgentXLandGato岡野原大輔東京ロボティクスAI model自己教師あり学習インピーダンス制御AnthropicDEATH STRANDINGAI ModelsIn-Context Learning(ICL)深層予測学習Claude 3.7 SonnetEric Johnson汎用強化学習AIZMO.AI日立製作所Factorio Learning EnvironmentMOBBY’SFLEOculus Questコジマプロダクションロンドン芸術大学モビーディック尾形哲也Deepseek-v3生体情報デシマエンジンGoogle Brainダイビング量子コンピュータAIRECGemini-2-FlashSound Controlアウトドアqubit汎用ロボットLlama-3.3-70BSYNTH SUPERAIスキャニングIBM Quantum System 2オムロンサイニックエックスGPT-4o-Mini照明Maxim PeterKarl Sims自動採寸ViLaInJoshua RomoffArtnome3DLOOKダリオ・ヒルPDDLZOZO NEXTハイパースケープICONATESizerジェン・スン・フアンニューサウスウェールズ大学ZOZO山崎陽斗ワコールHuggingFaceClaude SammutFashion Intelligence System立木創太スニーカーStable Audioオックスフォード大学Partial Visual-Semantic Embedding浜中雅俊UNSTREET宗教Lars KunzeWEARミライ小町Newelse仏教杉浦孔明GPT-4Vテスラ福井健策CheckGoodsコカ・コーラ田向権ソイル大学GameGAN二次流通食品VASA-1Tesla Bot中古市場Coca‑Cola Y3000 Zero SugarVoxCeleb2AIパズルジェネレーターTesla AI DayWikipediaDupe KillerCopilot Copyright CommitmentAniTalkerDolphinGemmaソサエティ5.0Sphere偽ブランドテラバース上海大学SIGGRAPH 2020バズグラフXaver 1000配信京都大学Wild Dolphin Projectニュースタンテキ養蜂立福寛SoundStreamトークナイザー東芝Beewiseソニー・ピクチャーズ アニメーション音声解析音声処理技術DIB-R倉田宜典フィンテック感情分析LumaGPT-4.1投資Fosters+Partners周 済涛Dream MachineGPT-4.1 mini韻律射影MILIZEZaha Hadid ArchitectsステートマシンNTTGPT-4.1 nano韻律転移三菱UFJ信託銀行ディープニューラルネットワークPerplexityLINE AI

【CEDEC2020】テストプレイや接待プレイができるAI技術でモリカトロンが目指すこと #CEDEC2020

2020年9月2日から9月4日までオンライン開催された国内最大のコンピュータエンターテインメント業界向け技術交流会「CEDEC 2020」にて、モリカトロン株式会社が行った「攻略、接待、変更に強いAIプレイヤー開発のためのアプローチ」というセッションを取材しました。

講演者は、3Dアクションゲームに関するAIを担当したエンジニアの竹内将氏と本間翔太氏、格闘ゲームに関するAIを担当した馬淵浩希氏。また、岡島学氏は3人の登壇者たちとともに共同研究・開発者としてチームに大きく貢献しました。イベントの直前にも取材したとおり、このセッションでは格闘ゲームでユーザーに合わせた手加減をする、いわばゲームの中のAIと、深層強化学習でビデオゲームを学習したAIによるテストプレイなどのQA、すなわち“ゲームの外側”における活用の可能性を検証しています。

すべての開発者がAI技術の恩恵を受けるために

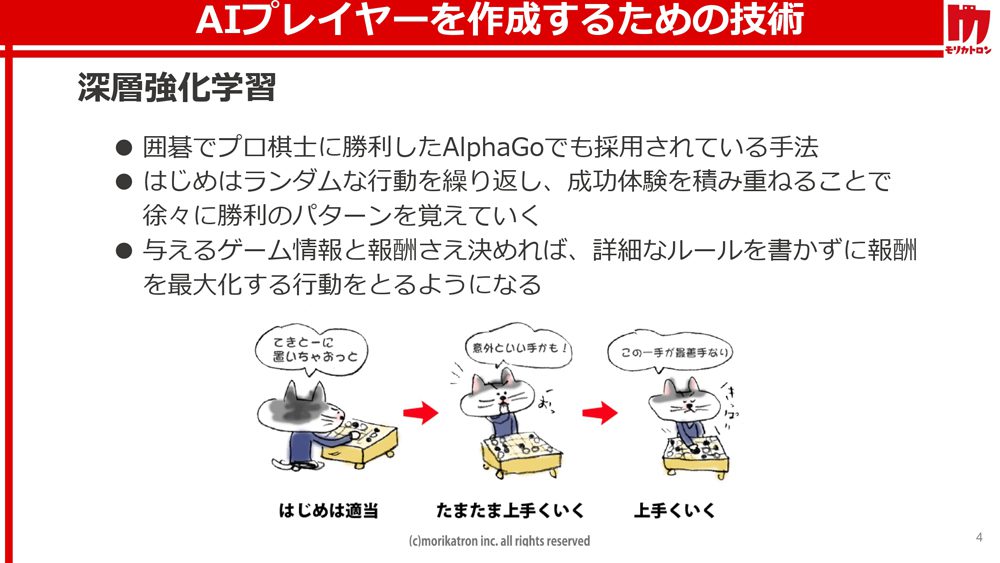

深層強化学習は、囲碁で人間のプロ棋士に勝利した「Alpha」シリーズにも採用されている手法で、完全にランダムな行動を繰り返す状態からスタートしたAIが、成功体験を積み重ねることで徐々に勝利のパターンを覚えていくというアルゴリズムです。その強みは、ゲーム情報と各行動の報酬さえ決めれば、人間が詳細なルールを書かずとも、AIが報酬を最大化する行動をとるように成長していく点にあります。

これまで囲碁や将棋でプロ棋士を凌駕しただけでなく、「ブロック崩し」で人間を超えるスコアを記録したり、『StarCraft II』(2010年、ブリザード・エンターテイメント)や『Dota 2』(2013年、Valve Corporation)といった不完全情報ゲームにおいても世界のトッププレイヤーを破ったりと、深層強化学習の研究は世界中で加速し続けており、多くの分野において着実な成果を残しています。

同時に、ただひたすらに人間に勝る強さのみを追求するのではなく、この技術を実際のゲーム開発に役立てようとする研究も、多くの企業が挑み続けている課題です。開発中のゲームをAIが攻略できるようになれば、テストプレイやデバッグといったQA(品質管理)に関わる業務を代行してもらえるかもしれません。また、対戦ゲームで適度に手加減できるAIプレイヤーが実現できれば、人間の良き遊び相手になってくれるかもしれません。

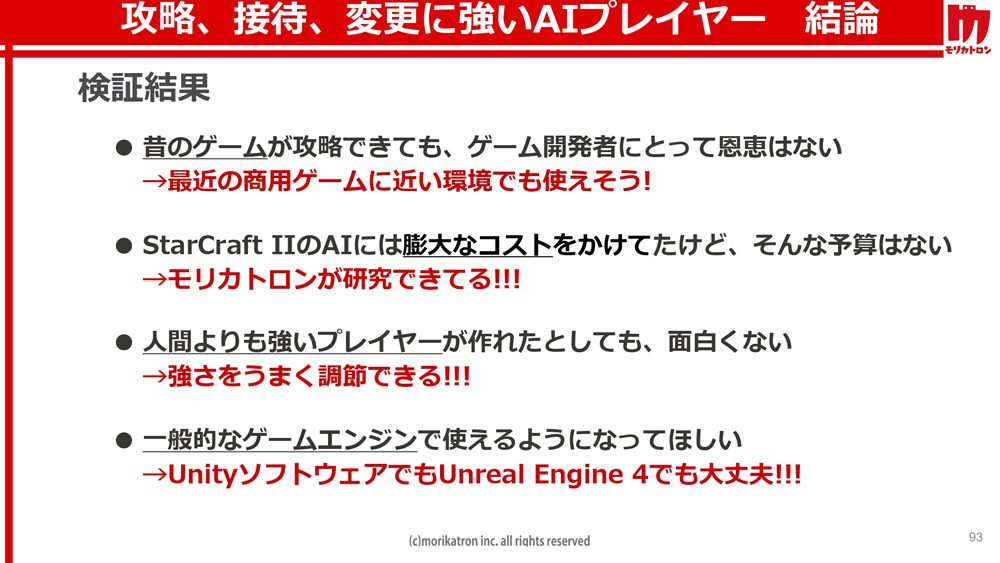

しかし、そうした夢を叶えるためには、まだまだ埋めるべき溝があるといいます。まず、研究用の環境で古いゲームが攻略できたとしても、最新の商用ゲームに対応できなければゲーム開発者にとって恩恵はありません。また、『StarCraft II』や『Dota 2』を使った研究では世界的な大企業が莫大な資金を投入しており、それと同等の計算コストはほとんどの企業にとって非現実的です。加えて、「Unity」や「Unreal Engine 4」(以下、UE4)のように広く普及しているゲームエンジンで使える技術でなくてはなりません。

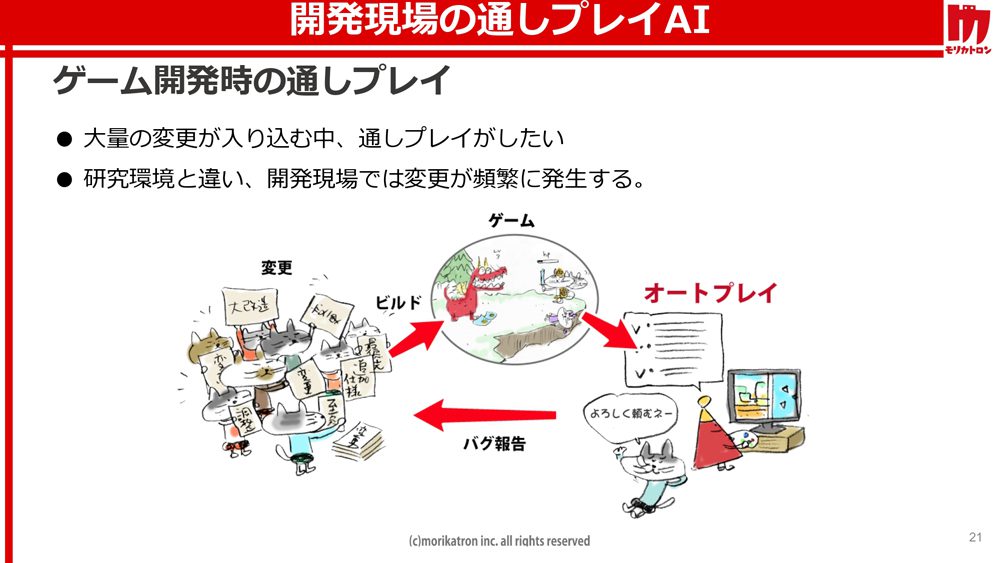

テストプレイを丸投げできるAIを目指して

これらの課題と向き合う第一歩としてモリカトロンが取り組んでいるのが、3Dアクションゲームを通しプレイできるAIの開発です。異なる職種の多人数が同時並行で進めるゲーム開発では、プログラムに日々大量の変更が発生します。そのたびに一通りテストプレイして、不具合がないか確認しなければなりません。これをAIで自動化するのが研究の狙いです。

ゲーム内では、AIが武器を取得したり、ステージ攻略に必要なギミックを作動させたり、敵を倒したりするたびに異なる数値の報酬が与えられます。なお、敵オブジェクトの検出にはレイキャストを用いています。手始めにプリセットのアルゴリズムを使ってデモデータなしで3日間学習させたところ、最初の報酬である武器の取得にすら到達できなかったといいます。また、プリセットに搭載されている教師あり学習と逆強化学習を利用した模倣学習を利用してもでもクリアには至らなかったようです。

そこでDQNに模倣学習を組み合わせた手法「DQfD(Deep Q-Learning from Demonstrations)」を採用。これはデモデータと過去の自分の行動の両方をサンプルとして学習させるアルゴリズムです。まず、お手本となる人間のデモプレイをもとに100万ステップの事前学習を実行しました。また、デモデータにおける行動を優先するようにlossを設定することで、人間によるテストプレイの動きをある程度再現しています。セッションにて公開された検証映像では、制限時間として設定された10分以内にAIが見事にボス戦を含めたサンプルステージを攻略できました。

模倣学習を使ったアプローチの最大の利点は、近年の3Dアクションゲームで顕著に見られる広大なマップを正しい手順で攻略できることです。完全なランダム行動では報酬が得られないような状況に柔軟に対応でき、探索数の削減により学習時間も大幅に短縮できます。また、キー操作の完全なコピーではないので、動く敵などのランダム要素や遅延にも強いといいます。さらに、数回のデバッグプレイをスケール化することも可能で、再現性の低いバグの検出にも役立つそうです。

一方で、大幅な仕様変更のたびにデモデータを作り直さなければならないという大きなデメリットもあります。変更の頻度によっては、デモデータの作成自体が困難になることも想定されるでしょう。そこで次に検証されたのが、デモプレイを一切使用しない階層型強化学習によるアプローチです。

AIは3Dアクションゲームを独学で覚えられるか

初期の検証にて、模倣なし学習で最初の報酬にすらたどり着けなかった原因は、ランダムな行動を繰り返すにはステージがあまりに広すぎることや、最初の報酬となる武器の位置が遠すぎるからでした。現実的な学習コストでクリアを目指すには、どうしても状況にある程度適したゲームプレイが求められます。

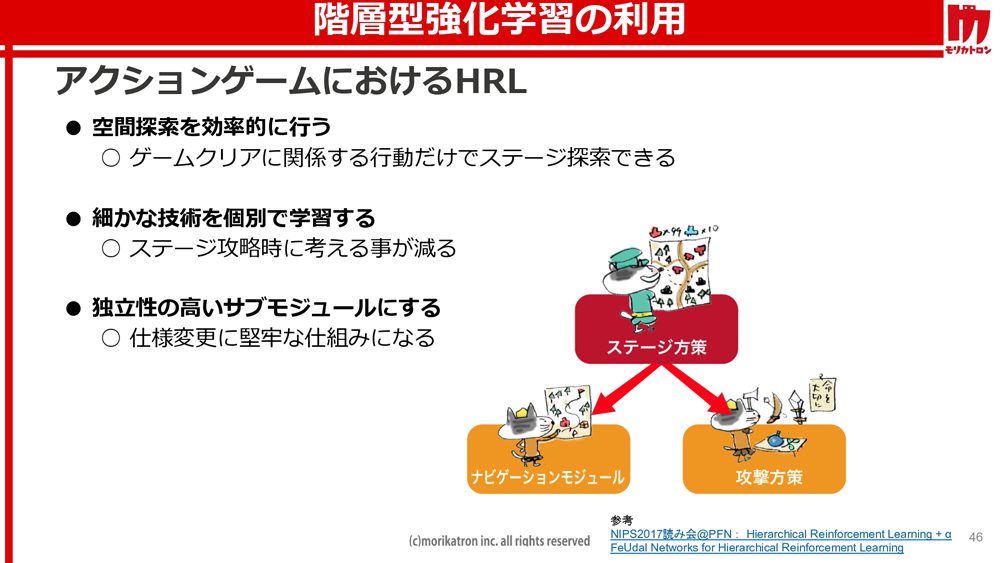

階層型強化学習は、意思決定を下位方策と上位方策に分けるアルゴリズムで、下位方策がキャラクターの移動や攻撃といったプリミティブな行動の選択を担うのに対して、上位方策はサブタスクとなる下位方策の選択を担当します。下位方策を使い回せるため汎化性能が高く、プロジェクトの仕様変更にも柔軟に対応できるという利点があります。

今回の検証では、「ナビゲーションモジュール」と「攻撃方策」という独立性の高いサブモジュールを用意。前者にはナビゲーションメッシュを利用したパス検索によるステージ内の移動を学習させ、後者には一定間隔でランダムな箇所に出現するオブジェクトを使って攻撃を学習させています。このように専用のタスクを個別に学習した各モジュールを上位の「ステージ方策」が状況にあわせて使い分けることで、ゲームクリアにつながる行動だけを選択してステージを探索できるという仕組みです。

このようなデモデータを使用しない学習には、現実的な学習コストで広大なマップを探索できることに加えて、デモデータの作成なしで再学習できるため継続的インテグレーションと連携できるという大きな利点があります。ゲーム固有の機能別にエンジニアリングを要するというデメリットはあるものの、実用化できれば完全な自動デバッグの実現も期待できそうです。しかし、現状では制限時間内のステージクリアは難しく、実際のゲーム開発に役立つAIへ成長するまでの道のりはまだまだ険しい印象を受けました。

格闘ゲームでAIにいろんな戦い方を教える方法

セッションの後半では、格闘ゲームを学習させたAIを使って人間相手に接待プレイは可能かどうかが検証されました。AIが人間の良き遊び相手になれない最大の理由は、強化学習によって対戦ゲームをマスターしたAIがほとんどの人間プレイヤーにとって強すぎるからです。このセッションでは、相手を楽しませることを接待プレイと定義しています。これは初心者から上級者まで幅広いプレイヤーを相手に、自分より格下だと思わせない強さで戦えて、かつ自然な方法で手加減することで白熱した試合が演出できるAIを意味します。

今回の検証には、UE4で作成された「Fighting Games Template Project」という、読んで字の如く2D格闘ゲームのテンプレートプロジェクトが使用されています。UE4にはUnityのように学習用のプラグインは存在しないため、PythonがTCPでUE4のゲームと通信する構成を自前で用意したということです。AIの学習はすべてPython側で処理しているほか、学習時間を短縮するために分散学習を行っているとのことでした。

強化学習で格闘ゲームに強いAIを作る際の問題点として、学習時の対戦相手によって学習結果に差が生まれることが挙げられます。例えば、下段蹴りを多用する相手に対しては下段ガードや飛び蹴りを多用する戦い方を学習しやすく、投げを多用する相手の場合は投げ抜けしやすいように同じく投げを多用したり、距離をとったりするような戦い方を学習しやすいとのこと。そのため、対戦相手が対抗策を講じれば一切勝てなくなってしまいます。

もうひとつの問題点は、報酬の与え方によって戦い方に差が生まれることです。例えば、時間経過にペナルティを課した場合、早く決着をつけようと攻撃的な戦い方を学習しやすく、攻撃の空振りにペナルティを課した場合、確実に攻撃をヒットさせようとカウンター重視の戦い方を学習しやすくなってしまいます。どのスタイルを採用するべきかという課題です。

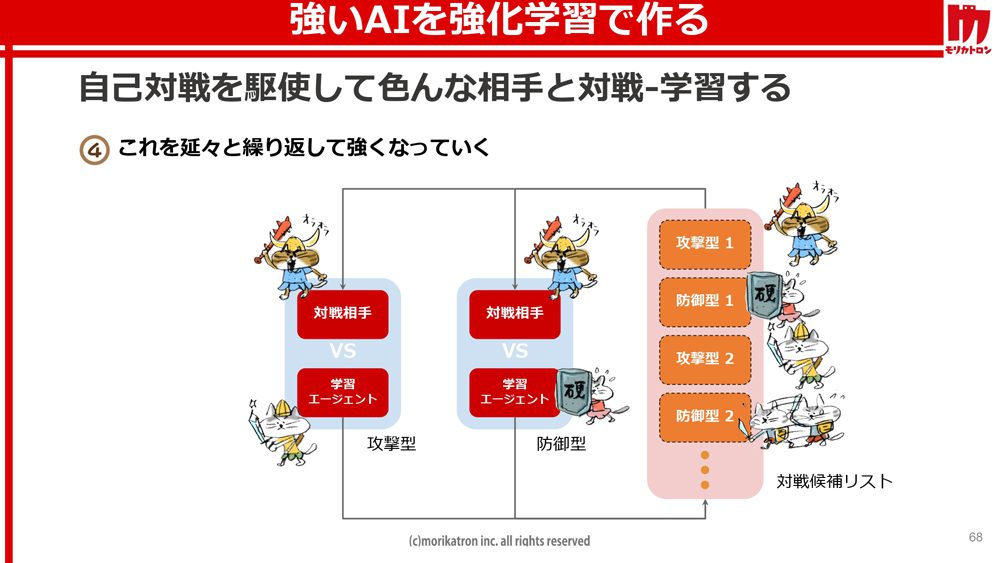

前者の問題は、複数の戦い方を同時に学習することで、自己対戦における対戦相手を一般化するという手法で解決しています。例えば、攻撃型と防御型といった報酬設計が異なる複数のエージェントを用意し、それぞれランダムに行動するAIと平行して戦わせます。この対戦を繰り返してエージェントがある程度まで強くなったら、今度はそれらを対戦候補としてリストに追加します。次に対戦相手として選ばれるのは、攻撃型か防御型どちらかを学習した過去の自分自身です。このループを繰り返すことで、特定のスタイルに縛られない強いAIを育成できるというわけです。

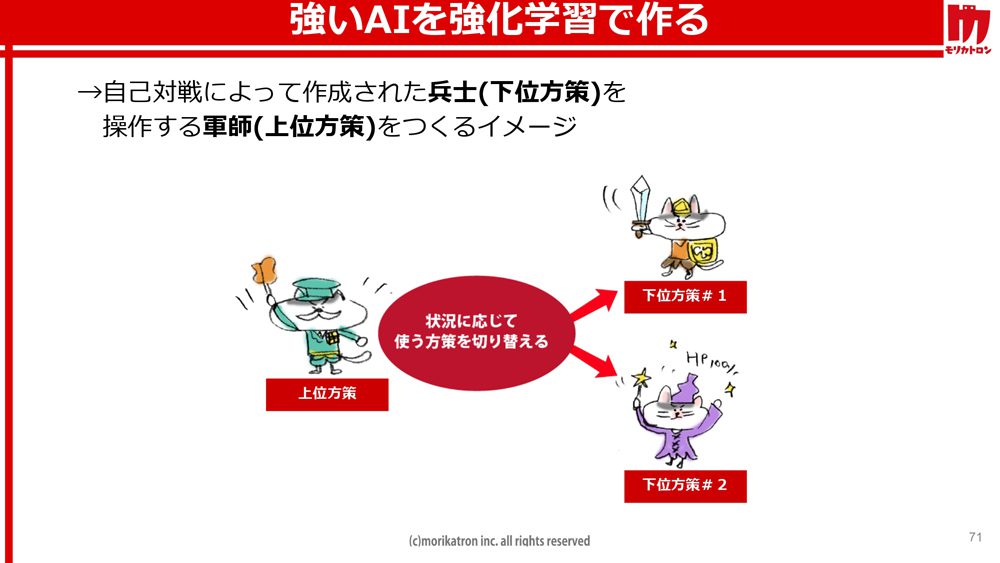

今度は、このように自己対戦によって作成したエージェントを下位方策と定義し、それらを状況にあわせて使い分けるよう上位方策となるエージェントに学習させます。攻撃型や防御型といった下位方策が兵士だとすれば、上位方策は彼らに命令を下す軍師のような存在です。下位方策がフレーム単位でパンチやキックといった行動を決定し、上位方策は秒単位で攻撃型や防御型といった戦略を決定します。こうした戦略の統合によって、後者の問題を解決しています。

プレイヤーの腕前に合わせて手加減してくれるAI

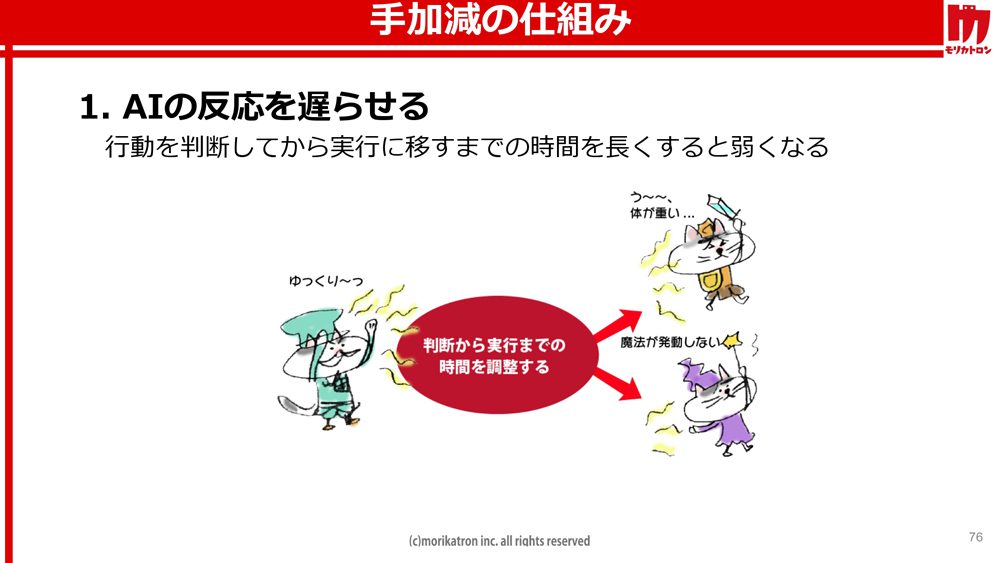

ここまでの検証で十分に強いAIは完成しました。このAIに手加減という行為を学習させるのが本題です。これには3つの方法が考案されています。まず、もっともシンプルで確実な効果が得られるのが、AIの反応速度を遅らせることです。AIにゲーム情報を与えるまでの時間を遅延させることで、AIは理想的なタイミングで攻撃や防御を行えなくなります。学習済みのニューラルネットワークに手を加える必要がないという利点もあります。

次に、下位方策の性能を落とすという方法が挙げられます。下位方策に上記の学習過程のようなニューラルネットワークを用いた場合、学習途中のエージェントを順次保存することで手加減の際に利用します。下位方策にルールベースAIを採用した場合、手加減時に使用するルールベースAIそのものを変更するだけで済みます。こうすることで各々の下位方策による行動が最適化できず、結果としてAIが弱体化するというわけです。

最後の手法は、司令塔である上位方策の性能を落とすことです。ここではWANN(Weight Agnostic Neural Networkの略)というアルゴリズムを利用しています。「重みを無視できるニューラルネットワーク」という名前のとおり、ニューラルネットワークの構造のみを変化させることで学習させる手法です。これにより、重みひとつで戦略の最適度をリアルタイムで連続的に制御できるようになります。結果、大局的な戦略においてAIは弱体化します。

今回の手法における最大のメリットは、カスタマイズ性の高さだといいます。学習後に調整が可能で、防御が苦手といった特定の弱点を作りやすいことから、ゲーム開発者の意図を反映させる余地が残されています。また、上位方策がランダムになっても、下位方策は経験から最適な行動を取ろうとするため、手加減がプレイヤーに伝わるほど不自然な動きになり辛いということでした。なお、上位方策や下位方策はルールベースにも置き換えられます。

共同研究者の岡島氏を相手にした接待プレイのデモンストレーションでは、お互いの体力差が可能な限り少なくなるよう見事に立ち回るAIが披露されました。序盤はAIの手加減を少なめに調整することで手強い相手を演出し、終盤になるほど多めに手加減することで人間側が勝ちやすいように戦ってくれます。なお、上位方策の性能に関してはプレイヤーの体力のみを参照して、接待相手がピンチになるほど性能を落とすように設計したということです。

今後の課題として、下位方策の組み合わせによってAIの性格を表現する方法を模索したいとのこと。また、より幅広いプレイヤーの接待に対応するためには、さらに強いAIを作成する必要があります。加えて、複数のニューラルネットワークを組み合わせた構成では学習コストが高くなってしまうので、分散学習以外の方法による学習時間の短縮も考えているそうです。もっとも重要なのは、本当の意味で接待プレイと呼べるようになるにはまだまだ検証が足りないということです。世がコロナ禍という状況になければ、多くの人にプレイしてもらい、統計データを取りたかったということでした。

AI技術が大衆化する将来を見据えて

今回、モリカトロンは3Dアクションゲームを通しプレイできるAIと、格闘ゲームを手加減しながらプレイできるAIの開発をとおして、AI技術を実際のゲーム開発に役立てる上で埋めるべき溝について検証しました。研究に使われたUnityとUE4は大企業からインディーズまで誰でも利用でき、開発規模に関わらず多くのゲームに使用されています。

まだ学習コストやアルゴリズムに改良の余地はあるとはいえ、モリカトロンの研究は最近の商用ゲームに近い環境でAI技術が役に立つ可能性を示しています。また、同社が使用したマシンは、Intel core i9-9900K 3.6GHz(64GB)のCPUに、NVIDIA TITAN RTX(24GB)のGPUと、大企業でなくとも十分負担できるスペックに収まっています。

ゲームの外側におけるAI技術の活用は、例年のCEDECで多くの企業が研究課題に選んでいる次世代への大きな一歩です。いまや誰もが汎用的なゲームエンジンを手に、個人規模でもゲーム開発を行える時代。これまで政府や大企業が莫大な予算を投入して発展させてきたAI技術が、近い将来にはゲームエンジン同様にもっと身近なツールとして広く普及するかもしれません。モリカトロンによる検証のような試みは、そうしたAI技術の大衆化を加速させる原動力ともいえるでしょう。

Writer:Ritsuko Kawai / 河合律子

RANKING

RANKING